Daten sind schon lange nicht mehr nur ein Nebenprodukt des Tagesgeschäfts, sondern die Grundlage für Entscheidungen, Innovation und Effizienz. Je größer jedoch die Datenmengen werden, desto wichtiger wird die Frage: Wie lassen sich diese Daten effizient speichern, analysieren und gewinnbringend nutzen? Genau hier kommen moderne Datenplattformen ins Spiel.

Ob Predictive Analytics, KI-gestützte Forecasts oder Self-Service-Reporting: Ohne eine leistungsfähige Data Platform bleibt das Potenzial von Daten oft ungenutzt. Der Markt bietet inzwischen eine Vielzahl an Lösungen: von offenen Lakehouse-Architekturen bis hin zu stark integrierten SaaS-Plattformen. Doch welche Platform passt zu Ihrem Unternehmen?

In diesem Beitrag geben wir Ihnen einen strukturierten Überblick über die wichtigsten Datenplattformen am Markt. Wir vergleichen Data Platforms nach ihre Stärken, Schwächen, Kostenmodelle und Einsatzszenarien und teilen unsere Perspektive aus der Praxis: Wann ist Microsoft Fabric oder Databricks die bessere Wahl – und wann eher nicht?

Für Sie auch interessant:

Lassen Sie uns mit dem Vergleich der Datenplattformen starten!

Was ist eine Datenplattform – und warum ist sie so wichtig für Unternehmen?

Eine Lakehouse Data Platform bildet das technologische Rückgrat datengetriebener Unternehmen. Sie verbindet verschiedene Datenquellen, sorgt für eine einheitliche Datenbasis und ermöglicht die Verarbeitung, Analyse und Visualisierung großer Datenmengen, idealerweise in Echtzeit.

Moderne Datenplattformen erfüllen dabei gleich mehrere Rollen:

- Datenintegration: Zusammenführen strukturierter und unstrukturierter Daten aus unterschiedlichsten Quellen (z. B. ERP, CRM, IoT).

- Verarbeitung & Speicherung: Skalierbare Infrastrukturen für Streaming, ETL, DWH und Data Lakes.

- Analytics & KI: Bereitstellung von Daten für Business Intelligence, Machine Learning und Advanced Analytics.

- Governance & Sicherheit: Einheitliche Richtlinien zur Datenqualität, Zugriffskontrolle und Compliance (z. B. DSGVO).

Warum ist das so wichtig?

Ohne eine integrierte Plattform entstehen Datensilos, inkonsistente Berichte und langwierige Abstimmungsprozesse. Mit einer Lakehouse Platform hingegen werden Daten zu einem strategischen Wettbewerbsvorteil und bilden die Basis für skalierbare Innovationen mit KI.

Aber jede Datenplattform ist anders aufgebaut. Je nachdem, wer die Lösungen anbietet, wie sie aufgebaut sind und wie sie betrieben werden, können sie sich stark unterscheiden. Das gilt sowohl für die Technik als auch für die Strategie. Damit Sie die richtige Wahl treffen können, lohnt es sich, einen Blick auf die grundlegenden Plattform-Typen zu werfen.

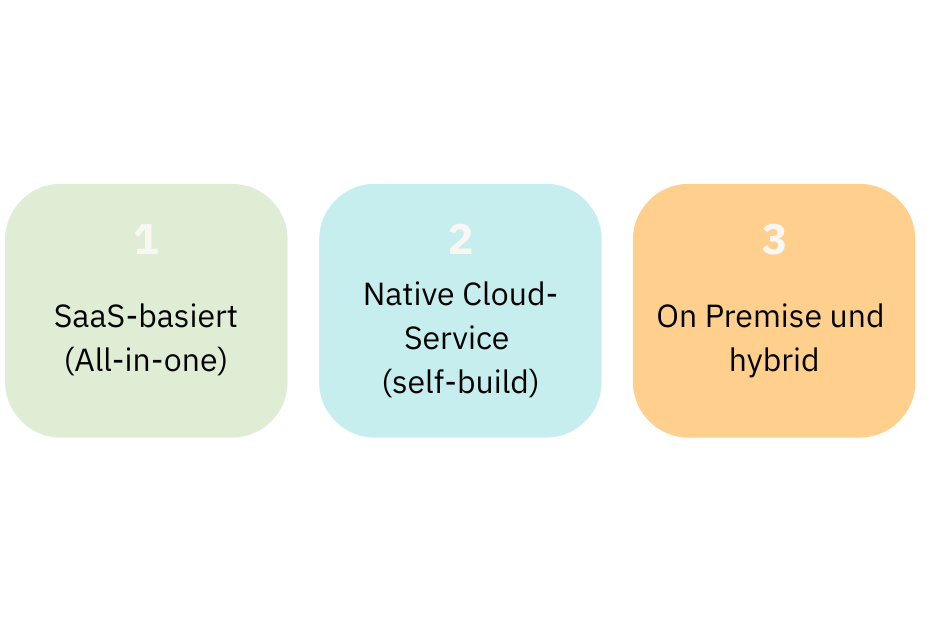

Welche Arten von Data Platforms gibt es?

Nicht jede Datenplattform ist gleich aufgebaut, weder in Bezug auf ihre Architektur noch auf ihr Betriebsmodell. Im Wesentlichen lassen sich drei Hauptkategorien unterscheiden, die sich stark auf Flexibilität, Kosten, Wartungsaufwand und Integrationsfähigkeit auswirken.

1. SaaS-basierte All-in-One-Plattformen

Diese Plattformen werden als vollständig verwaltete Dienste in der Cloud betrieben. Sie bieten eine breite Palette an Funktionen – von Datenintegration über Speicherung und Analyse bis hin zu KI und Reporting – alles über eine zentrale Oberfläche nutzbar.

Beispiele:

- Microsoft Fabric

- Databricks

- Snowflake

- Palantir Foundry (kommerziell, stark integriert)

Vorteile:

- Geringer Betriebsaufwand, da Wartung und Skalierung übernommen werden

- Schnelle Time-to-Value dank vorkonfigurierter Funktionen

- Ideal für Unternehmen mit kleinen bis mittelgroßen Data-Teams

Nachteile:

- Eingeschränkte Anpassbarkeit

- Abhängigkeit vom Anbieter (Vendor Lock-in)

- Teilweise höhere Laufzeitkosten bei großem Datenvolumen

2. Native Cloud Services (Self-built Data Platforms)

Statt auf eine monolithische Plattform zu setzen, können Unternehmen auch einzelne Cloud-Komponenten (z. B. Storage, Compute, ETL, ML) kombinieren und individuell orchestrieren. Diese Strategie erfordert jedoch fundiertes Know-how und ein eigenes Entwickler Team mit Erfahrung im Bereich Data Engineering, Netzwerk/Sicherheit und DevOps.

Beispiele:

- Azure Synapse + Azure Data Factory + Azure ML

- Databricks (modular nutzbar)

- AWS (S3, Glue, Redshift, SageMaker)

- Google Cloud Platform (BigQuery, Vertex AI etc.)

Vorteile:

- Hohe Flexibilität und Anpassbarkeit

- Offenere Architektur, oft mit Open Source-Komponenten

- Optimiert für Unternehmen mit spezifischen Anforderungen

Nachteile:

- Komplex in der Wartung

- Hoher Bedarf an DevOps/Data Engineering Know-how

- Kein „Single Point of Control“ – höhere Governance-Herausforderungen

3. On-Premise und hybride Enterprise-Plattformen

Diese Plattformen richten sich oft an große Konzerne mit hohem Sicherheits- und Compliance-Bedarf oder Legacy-Systemen, die nicht einfach in die Cloud verschoben werden können. Sie bieten umfangreiche Governance-Funktionen und sind häufig tief in ERP- und Produktionssysteme eingebettet.

Beispiele:

- SAP Business Data Cloud (BDC)

- SAS Viya

- Palantir Foundry (auch Hybrid-Szenarien)

Vorteile:

- Volle Kontrolle über Datenhaltung und Infrastruktur

- Ideal bei regulatorischen Anforderungen oder Netzwerkeinschränkungen

- Oft tiefe Integration mit Unternehmensprozessen (z. B. SAP)

Nachteile:

- Langsame Implementierung

- Teure Lizenzmodelle und Betriebskosten

- Weniger innovationsgetrieben als Cloud-native Anbieter

Je nach Unternehmensgröße, technischer Reife und Datenstrategie bieten die verschiedenen Plattformarten unterschiedliche Vor- und Nachteile. Doch wie unterscheiden sich die konkreten Lösungen im Detail?

Im nächsten Kapitel stellen wir die wichtigsten Anbieter – von Microsoft Fabric über Databricks bis hin zu SAP BDC – vor und zeigen ihre jeweiligen Besonderheiten.

Die wichtigsten Plattformen im Überblick

Der Markt für Datenplattformen ist in den letzten Jahren stark gewachsen. Einige Anbieter konzentrieren sich auf einfache Datenanalysen, andere bieten umfassende End-to-End-Plattformen für komplexe AI- und Data-Engineering-Workloads.

Hier stellen wir Ihnen die 7 wichtigsten Plattformen vor, die in Unternehmen jeder Größe und Reife zum Einsatz kommen. Wir zeigen Ihnen jeweils den Fokus auf Technologie, Besonderheiten und typische Einsatzbereiche.

Microsoft Fabric

Microsoft Fabric ist die jüngste Plattform im Portfolio von Microsoft (2023) und bündelt Technologien wie Power BI, Azure Data Factory, Synapse, Delta Lake und Copilot in einem einzigen SaaS-Angebot. Ziel ist es, eine einheitliche Umgebung für Datenintegration, -analyse und -bereitstellung zu schaffen – von Self-Service BI bis hin zu fortgeschrittener KI.

Besonderheiten:

- Einheitliches Kapazitätsmodell (Capacity Units)

- Native Integration mit Power BI und Azure ML

- OneLake als zentrales Data-Lake-Storage für alle Workloads

- Governance mit Microsoft Purview

Einsatz:

Ideal für Unternehmen im Microsoft-Ökosystem, die eine vollständig verwaltete, skalierbare Lösung mit starker BI-Integration suchen. Weitere Informationen finden Sie auf der Microsoft Homepage

Ist Fabric die passende Plattform für Ihren Business Case?

Jetzt Fabric Beratung mit Datasolut starten

Databricks

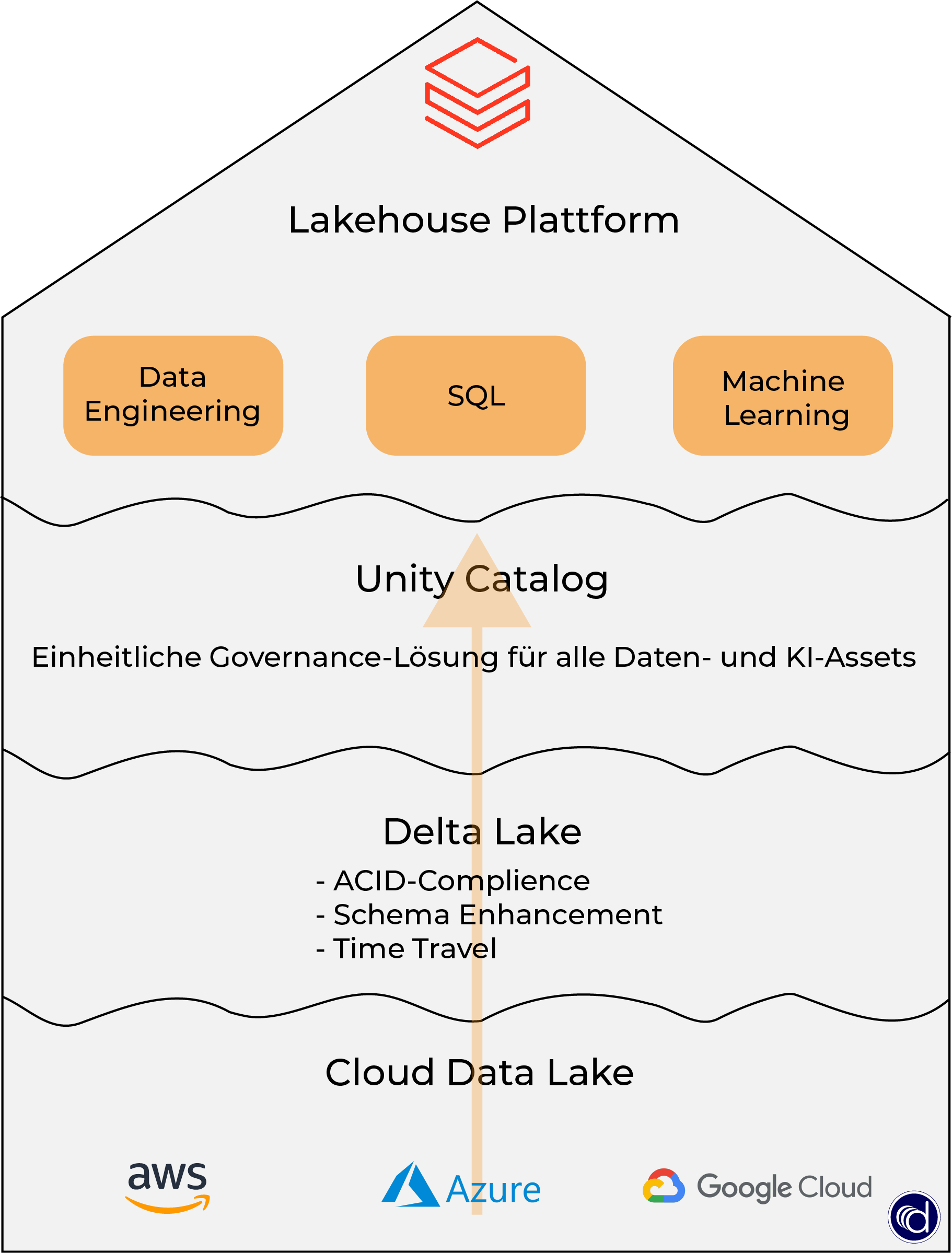

Databricks wurde 2013 von den Schöpfern von Apache Spark gegründet und gilt als Vorreiter des Lakehouse-Paradigmas – einer Architektur, die die Vorteile von Data Lakes und Data Warehouses vereint. Die Plattform fokussiert sich stark auf Machine Learning, AI und offene Standards.

Besonderheiten:

- Unterstützt Delta Lake, MLflow, Unity Catalog (alles Open Source)

- Native Notebooks und ML Pipelines

- Starkes Partnernetzwerk und Multi-Cloud-Fähigkeit (Azure, AWS, GCP)

- Führend im Gartner Magic Quadrant 2024 & 2025 (Data Science & DBMS)

Einsatz:

Besonders geeignet für Unternehmen mit datenwissenschaftlichem Fokus oder komplexen Analytics-Anforderungen, die ein hohes Maß an Flexibilität wünschen. Weitere Informationen finden Sie auf der Databricks Homepage

Wir sind offizieller Databricks Partner und beraten Sie gerne.

Passt Databricks oder Fabric besser zu den Bedürfnissen Ihres Unternehmens? Der Beantwortung der Frage sind wir in unserem Blog nachgegangen: Fabric vs. Databricks

Snowflake

Snowflake ist eine vollständig verwaltete Cloud-Datenplattform, die sich vor allem durch Benutzerfreundlichkeit und flexible Skalierung auszeichnet. Sie wurde ursprünglich für Data Warehousing entwickelt, unterstützt mittlerweile aber auch Data Sharing, semi-strukturierte Daten und einfache ML-Anbindungen.

Zum Blog: Databricks vs. Snowflake: Was sind die Unterschiede?

Besonderheiten:

- Trennung von Speicher und Compute (Abrechnung nach Credits)

- Integriertes Data Marketplace und sichere Datenfreigabe

- Proprietäres Datenformat (kein Delta Lake)

- Fokus auf SQL-zentrierte Workloads

Einsatz:

Attraktiv für Unternehmen mit klaren BI-Anforderungen, die eine stabile, wartungsarme Plattform suchen – weniger geeignet für komplexe AI-Projekte. Mehr erfahren Sie auf der Homepage von Snowflake

SAP Business Data Cloud (BDC / Datasphere)

SAP BDC (ehemals SAP Data Warehouse Cloud) richtet sich vor allem an Unternehmen mit bestehender SAP-Infrastruktur. Die Plattform bietet integriertes Datenmanagement, Reporting und Analysefunktionen – sowohl für SAP- als auch Non-SAP-Daten durch integrierte Databricks Schnittstelle: SAP Dataricks.

Besonderheiten:

- Echtzeit-Zugriff auf SAP-Quellsysteme

- Integrierte Governance und Business Layer

- Fixed-Capacity-Preismodell (Always-on)

- Proprietäre Datenhaltung, betrieben auf Hyperscalern (AWS, Azure, GCP)

Einsatz:

Ideal für Konzerne mit zentralem ERP-System von SAP – weniger flexibel bei offenen Integrationen oder AI-Szenarien. Hier finden Sie mehr Infos

Palantir Foundry

Palantir Foundry ist eine Platform, die ursprünglich für staatliche und sicherheitskritische Anwendungen entwickelt wurde. Heute unterstützt sie auch Unternehmen bei der Operationalisierung und Analyse komplexer Daten – mit einem Fokus auf Ontologien, Governance und kollaborative Workflows.

Besonderheiten:

- Visuelles, objektbasiertes Datenmodell

- Starke Governance-Mechanismen

- Kombination aus Low-Code-Interfaces und programmatischer Steuerung

- Eher proprietär, langfristige Vertragsmodelle

Einsatz:

Geeignet für Konzerne mit stark vernetzten operativen Datenflüssen und hohem Sicherheitsanspruch – weniger verbreitet im Mittelstand. Hier kommen Sie zur Palantir Homepage

SAS Viya

SAS ist seit Jahrzehnten eine feste Größe im Bereich Advanced Analytics und Statistik. Mit der Plattform Viya bietet das Unternehmen eine moderne Cloud-Umgebung für Datenmanagement, Machine Learning und Forecasting – insbesondere für regulierte Branchen.

Besonderheiten:

- Starke ML- und Forecasting-Funktionen

- Proprietäre Modellierungs- und Datenformate

- Deployment auch On-Premise oder hybrid möglich

- Fokus auf erklärbare KI (Explainable AI)

Einsatz:

Relevanz in stark regulierten Branchen (z. B. Pharma, Banken) mit Fokus auf statistische Verfahren und stabile AI-Pipelines. Zur SAS Viya LandingPage

Azure Synapse + Azure Data Factory (modular)

Synapse Analytics und Data Factory sind Bestandteil der Azure-Plattform und können einzeln oder kombiniert genutzt werden. Im Gegensatz zu Fabric setzt Microsoft hier auf einen modularen Ansatz – ideal für Unternehmen, die ihre Data Platform schrittweise aufbauen wollen.

Besonderheiten:

- SQL, Spark, Pipelines & Notebooks kombinierbar

- Vollständig in Azure integriert

- Flexible Preisgestaltung (nach Kapazität oder Aktivität)

- Open Format möglich (z. B. Delta Lake via Databricks)

Einsatz:

Geeignet für Unternehmen, die bereits auf Azure setzen und hohe Anpassbarkeit schätzen – aber mehr Aufwand in Betrieb und Architektur investieren können. Hier kommen Sie zur Azure Homepage

Wir sind Azure Partner und beraten Sie gerne.

Nach dieser kompakten Einführung in die wichtigsten Anbieter stellt sich die Frage: Wie schneiden diese Plattformen im direkten Vergleich ab – in Bezug auf Funktionen, Kosten, AI-Fähigkeit und Governance?

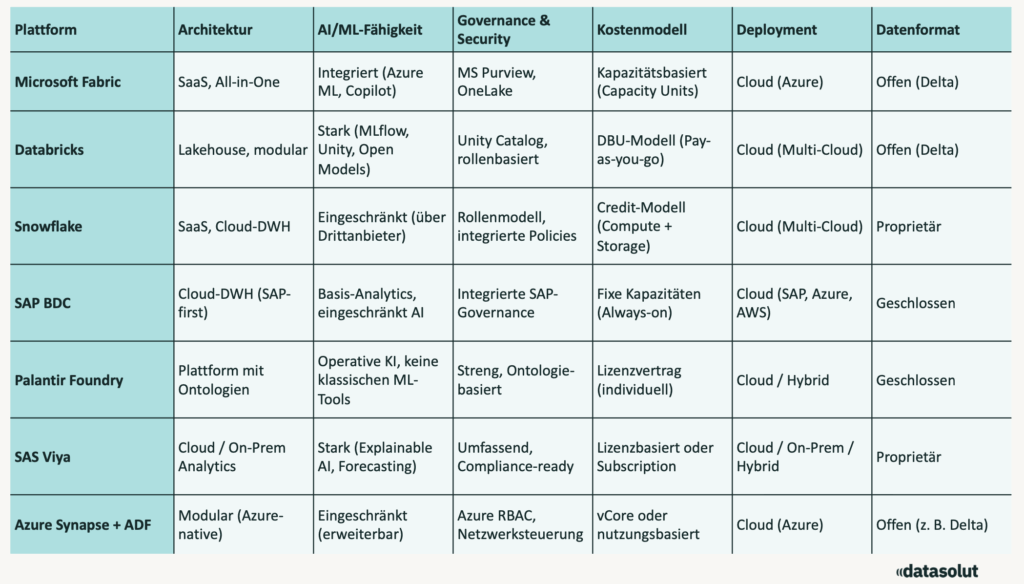

Vergleich der Plattformen – Funktionen, Kosten und Einsatzbereiche

Die folgende Tabelle bietet eine strukturierte Gegenüberstellung der wichtigsten Datenplattformen entlang zentraler Entscheidungskriterien. Damit erhalten Sie auf einen Blick Orientierung zu Architektur, KI-Fähigkeiten, Kostenmodell, Governance und mehr.

Erläuterungen zu den Vergleichskriterien

- Architektur: Gibt an, ob es sich um ein geschlossenes SaaS-System, eine offene modulare Plattform oder eine hybride Lösung handelt.

- AI/ML-Fähigkeit: Relevanz für Machine Learning, generative KI und Integration von Modellen.

- Governance: Welche Sicherheits- und Steuerungstools stehen bereit – z. B. Rollen, Kataloge, Ontologien.

- Kostenmodell: Abrechnung nach Zeit, Nutzung, Kapazität oder Lizenz.

- Deployment: Gibt an, ob die Plattform cloud-only, hybrid oder auch on-premise einsetzbar ist.

- Datenformat: Offen = z. B. Delta Lake, Parquet; Geschlossen = proprietäre Speicherformate.

Wenn man die Plattformen nüchtern vergleicht, sieht man: Es gibt keine, die per se „die beste“ ist. Je nachdem, was man braucht, sind die Stärken unterschiedlich. Deshalb ist es auch wichtig, sich von externen Experten helfen zu lassen.

Im nächsten Abschnitt schauen wir uns daher aktuelle Studien an, zum Beispiel von Gartner und Forrester, und zeigen, welche Plattformen 2024 und 2025 vorne liegen.

Analystenbewertungen: Wer sind die führenden Plattformen?

Es lohnt sich, auch unabhängige Marktanalysen zu prüfen, neben den technischen Funktionen und den betriebswirtschaftlichen Faktoren. Besonders die Bewertungen von Gartner, Forrester oder IDC helfen Ihnen bei der Auswahl einer Plattform. Dabei geht es vor allem um Marktdurchdringung, Innovationskraft und Kundenzufriedenheit.

Hier stellen wir Ihnen zentrale Erkenntnisse aus aktuellen Studien vor und ordnen sie kritisch ein.

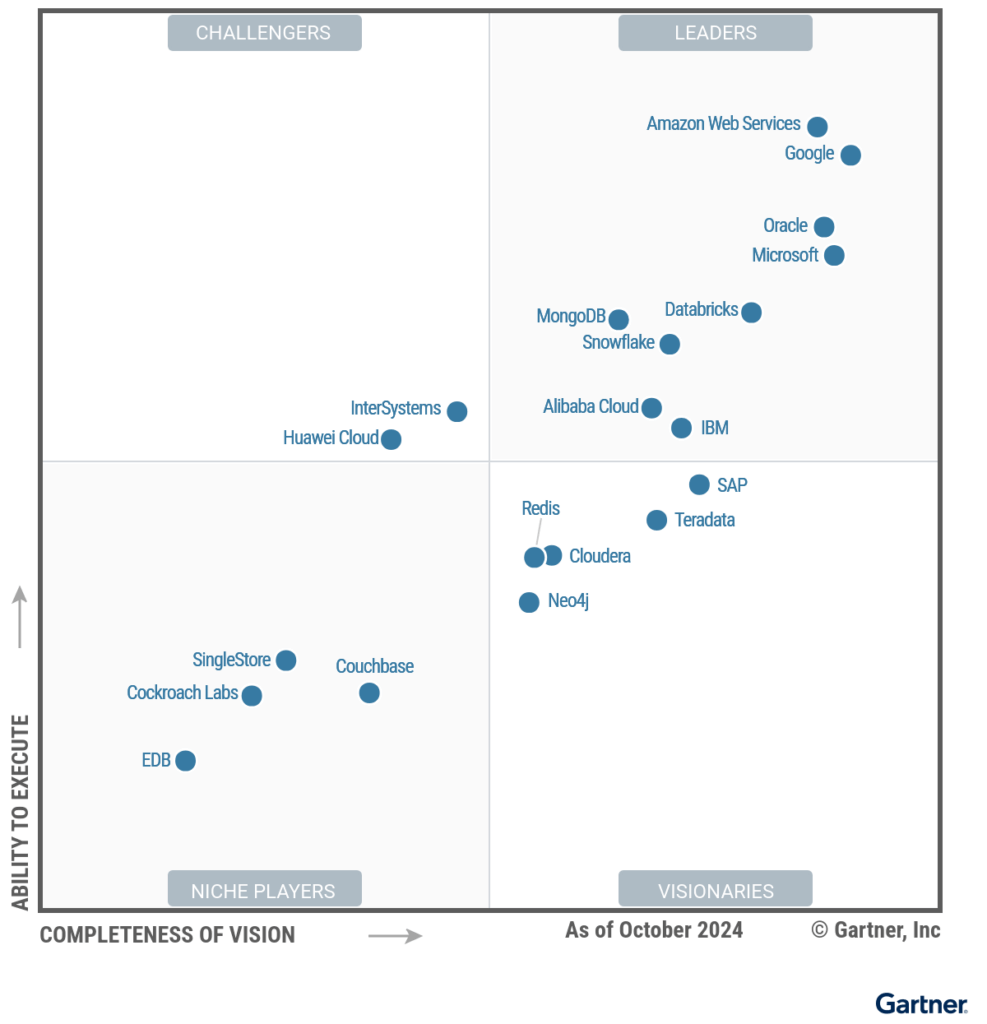

Gartner Magic Quadrant 2024: Cloud Database Management Systems (DBMS)

Im Gartner Magic Quadrant für Cloud-Datenbankmanagementsysteme 2024 wurde Databricks als Leader eingestuft – und das neben Branchengrößen wie Snowflake, Google und Microsoft.

Der „Magic Quadrant“ bewertet Technologieanbieter anhand ihrer Umsetzungsstärke („Ability to Execute“) und Zukunftsvision („Completeness of Vision“). Grundlage sind Daten aus Anbieterbriefings, Kundeninterviews und Marktanalysen. Auf dieser Basis ordnet Gartner die Anbieter in vier Kategorien ein: Leader, Challengers, Visionaries und Niche Player – und bietet so eine fundierte Entscheidungsgrundlage für Technologiekäufe.

Hier gelangen Sie zur Studie: Magic Quadrant for Cloud Database Management Systems

Besonders hervorgehoben wurden:

- Die konsequente Weiterentwicklung des Lakehouse-Ansatzes

- Die hohe Innovationsgeschwindigkeit (z. B. Unity Catalog, Mosaic AI)

- Die starke Performance bei großen, komplexen Workloads

Microsoft Fabric war in diesem Segment noch nicht eigenständig gelistet, da es als übergreifendes SaaS-Angebot auf bestehenden Azure-Komponenten wie Synapse und SQL DB basiert. Die zugrunde liegenden Technologien gelten jedoch als solide etablierte „Challenger“.

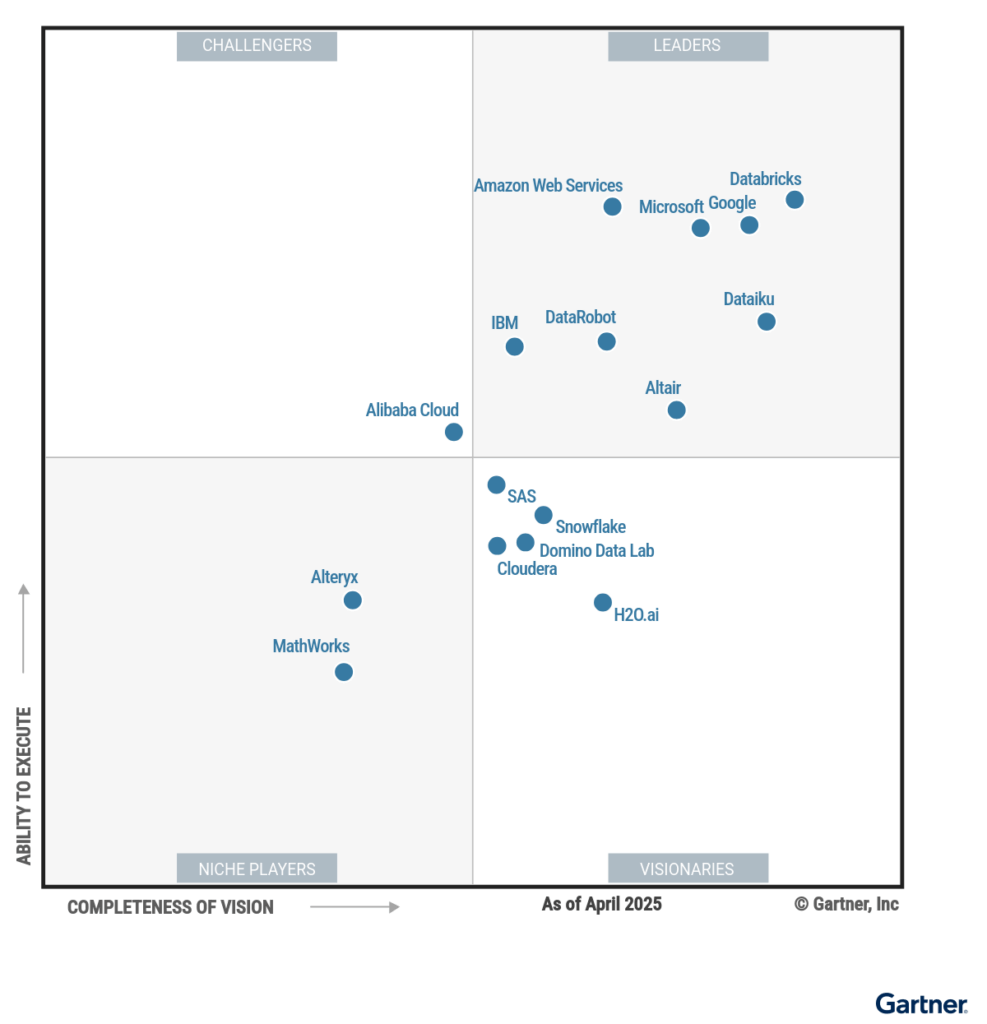

Gartner Magic Quadrant 2025: Data Science & Machine Learning Platforms

In der Bewertung für Data Science & Machine Learning Plattformen 2025 wurden sowohl Databricks als auch Microsoft (mit Azure ML & Fabric) als Leader klassifiziert.

Gartner bewertet in seinem Magic Quadrant DSML-Plattformen danach, wie gut sie am Markt performen und wie klar ihre Vision für moderne KI ist. Basis sind Kriterien wie Produktreife, Innovationskraft und Kundenfeedback. Für die Aufnahme müssen Anbieter u. a. eine professionelle Nutzerbasis, solide Umsätze und moderne KI-Funktionen wie GenAI und MLOps bieten. Hier kommen Sie zu den Studienergebnissen.

Gartner lobte bei beiden:

- die End-to-End-Unterstützung von Data Engineering bis Model Deployment

- die Open-Source-Strategie (z. B. MLflow, Delta Lake bei Databricks)

- die nahtlose Integration von generativer KI (Copilot, Mosaic AI)

Im Vergleich dazu schnitt Snowflake weniger stark ab: Zwar bietet die Plattform mittlerweile Anbindungen an externe ML-Engines (z. B. über Snowpark oder Drittanbieter), doch echte Modellierungs- und Trainingsmöglichkeiten fehlen im Kernprodukt.

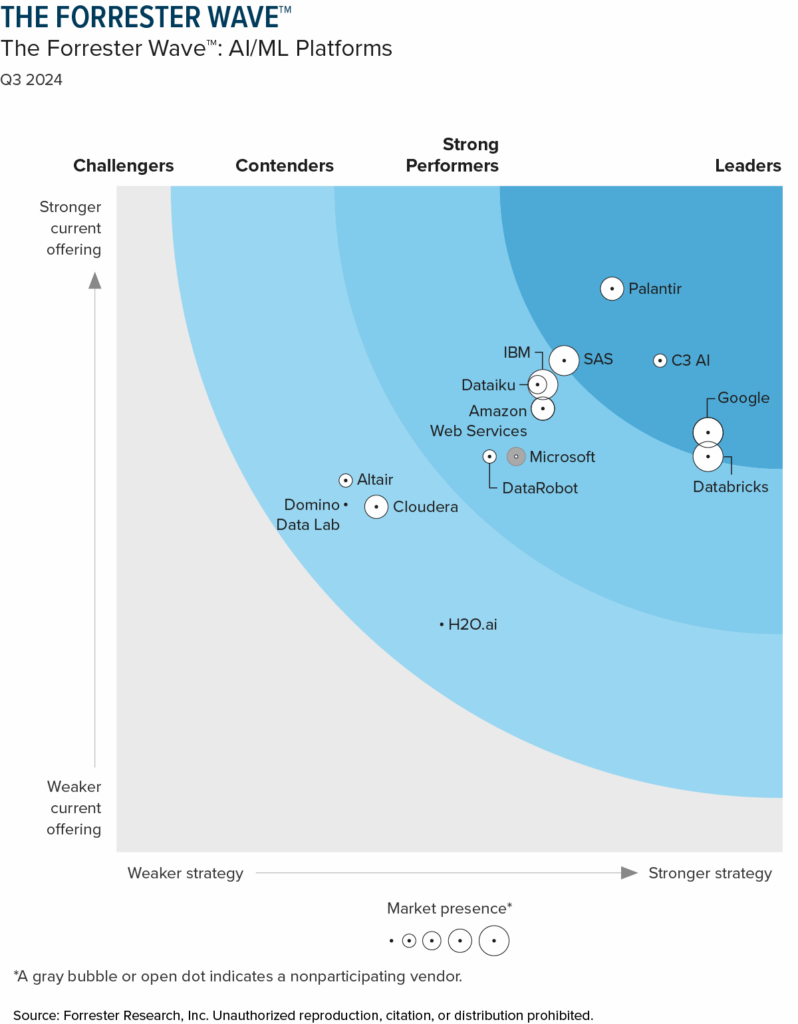

Forrester Wave™: AI/ML Platforms, Q3 2024

Die Forrester Wave™ bewertet 14 führende Anbieter von AI/ML-Plattformen anhand von 19 Kriterien in den Kategorien Produktangebot, Strategie und Marktpräsenz. Ziel ist es, Unternehmen eine fundierte Entscheidungshilfe bei der Auswahl von Plattformen für prädiktive KI und Generative AI zu geben.

Im Fokus der Bewertung stehen Plattformen, die kollaboratives Arbeiten über verschiedene Rollen hinweg ermöglichen – von Data Scientists über Entwickler bis hin zu Fachbereichen. Besonders hervorgehoben werden Vision, Governance-Funktionen, Benutzerfreundlichkeit und der Umgang mit aktuellen Trends wie GenAI und Agentic AI. Nur Anbieter mit relevanter Marktpräsenz, mindestens zehn zahlenden Unternehmenskunden und aktivem Enterprise-Fokus wurden berücksichtigt.

Das Ergebnis ist eine übersichtliche Matrix aus Leaders, Strong Performers, Contenders und Challengers, die aufzeigt, welche Plattformen technologische Innovationskraft mit unternehmerischem Fokus vereinen.

Die Forrester Wave™ 2024 zeigt, dass Palantir, Google, C3 AI, Databricks und SAS zu den führenden Anbietern im Markt für AI/ML-Plattformen zählen – sie überzeugen durch starke Visionen, moderne GenAI-Funktionen und umfassende Toolsets für verschiedene Nutzerrollen.

Anbieter wie IBM, Dataiku und AWS liefern ebenfalls solide Plattformen, haben aber noch Potenzial bei Skalierbarkeit oder Usability. Insgesamt zeigt sich: Erfolgreiche Plattformen kombinieren klassische ML-Funktionen mit generativer KI und setzen auf kollaborative, governance-fähige Umgebungen.

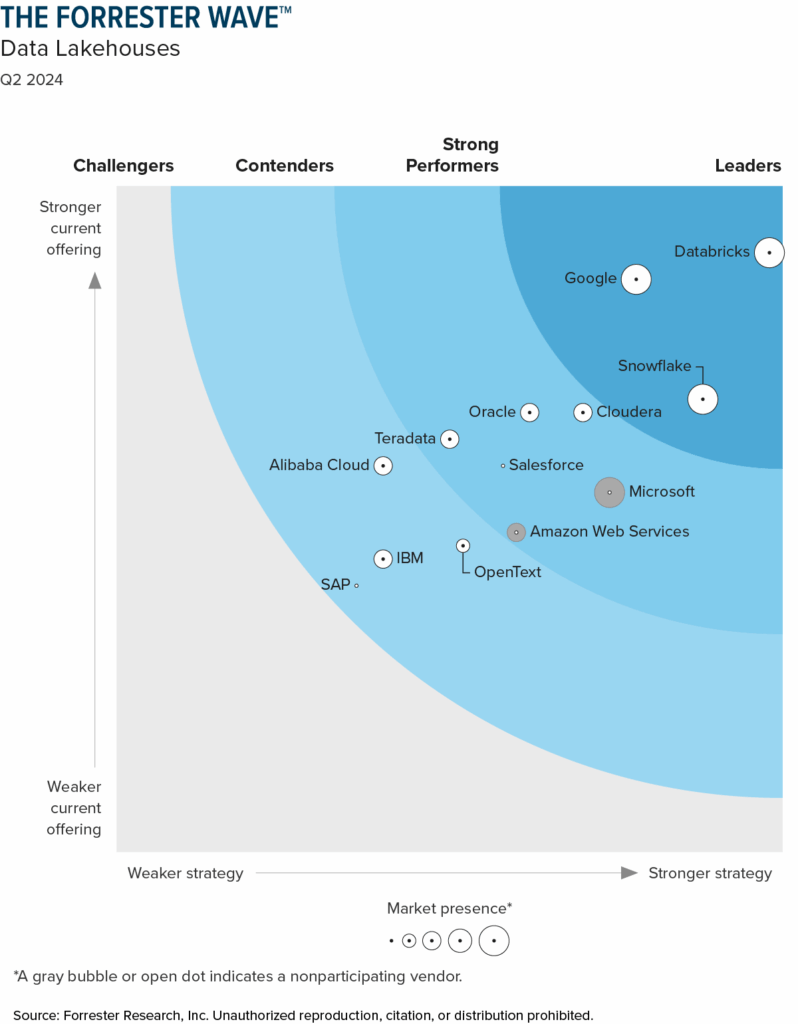

The Forrester Wave™: Data Lakehouses, Q2 2024

Die Forrester Wave™: Data Lakehouses, Q2 2024 bewertet 13 Anbieter nach Funktionen, Strategie und Marktpräsenz. Im Fokus stehen Skalierbarkeit, Datenintegration, Governance und GenAI-Fähigkeiten. Als führende Plattformen nennt Forrester Databricks, Google und Snowflake – sie überzeugen durch starke Roadmaps, moderne KI-Features und durchgängige Plattformintegration.

Anbieter wie Microsoft, Cloudera und AWS schneiden solide ab, zeigen aber noch Schwächen bei Innovation oder Benutzerfreundlichkeit. Die Studie zeigt klar: Wer heute in eine Datenplattform investiert, sollte neben Technik auch die langfristige Entwicklungsstrategie und KI-Tauglichkeit der Anbieter bewerten. Zur Studie

Weitere Beobachtungen:

- Palantir Foundry wird von Analysten oft als Speziallösung beschrieben: stark im operativen Kontext (z. B. Militär, Logistik), aber weniger offen und skalierbar für klassische Analytics-Stacks.

- SAP BDC taucht in den MQ-Bewertungen meist unter dem Oberbegriff „Data Integration Tools“ oder „Analytics Platforms“ auf – jedoch selten als Leader.

- SAS Viya wird insbesondere in regulierten Branchen (z. B. Pharma, Finanzwesen) weiterhin hoch bewertet – vor allem wegen starker Governance und statistischer Tiefe.

Hier nochmal die Analystenbewertungen vereinfacht gegenübergestellt:

| Plattform | Gartner MQ DBMS 2024 | Gartner MQ DSML 2025 | Forrester / Marktbeobachtung |

|---|---|---|---|

| Databricks | Leader | Leader | Innovativ, wachsend, AI-fokussiert |

| Microsoft Fabric | – (Teil von Azure) | Leader | Hohe Integration, Microsoft-Ökosystem |

| Snowflake | Leader | N/A (nicht gelistet) | BI-fokussiert, eingeschränkt für AI |

| SAP BDC | N/A | N/A | ERP-nah, eingeschränkt offen |

| Palantir Foundry | N/A | N/A | Speziallösung, eingeschränkte Adaption |

| SAS Viya | N/A | Niche Player | Stabil in regulierten Umfeldern |

Die Bewertungen zeigen: Databricks und Microsoft Fabric sind nicht nur technologisch stark, sondern auch strategisch gut positioniert. Sie haben klare Stärken in den Bereichen KI, Offenheit und Skalierbarkeit.

Im nächsten Kapitel geben wir Ihnen unsere Einschätzung: In welchen Fällen ist welche Plattform die richtige Wahl – und warum wir besonders Fabric und Databricks empfehlen.

Unsere Empfehlung: Wann Databricks oder Fabric die richtige Wahl ist

Die bisherigen Kapitel zeigen: Es gibt nicht die eine beste Lakehouse Data Platform – aber sehr wohl die richtige Plattform für Ihre individuellen Ziele. Aus unserer Erfahrung mit über 100 produktiven KI-Projekten und zahlreichen Plattform-Migrationen kristallisieren sich zwei Technologien besonders häufig als strategisch sinnvoll heraus: Microsoft Fabric und Databricks.

Doch welche passt zu welchem Unternehmen? Und wie findet man überhaupt heraus, wo man starten sollte?

Unsere Empfehlung für Microsoft Fabric

Microsoft Fabric bietet sich an, wenn Sie bereits stark im Microsoft-Ökosystem arbeiten – z. B. mit Power BI, Azure SQL, Excel oder Teams. Die Plattform überzeugt durch:

- Schnelle Time-to-Value durch vollständig verwaltete Infrastruktur

- Nahtlose BI-Integration (Power BI ist direkt eingebettet)

- Zentrale Datenspeicherung in OneLake

- Einheitliches Kapazitätsmodell für Planungssicherheit

- Gute Einstiegsmöglichkeiten für Self-Service-Analytics und KI

Typische Szenarien:

- Einführung einer einheitlichen Reporting- und Analytics-Plattform

- Datendemokratisierung in Fachbereichen

- Aufbau von KI-Anwendungen auf vorhandenen Azure-Daten

Unsere Empfehlung für Databricks

Databricks eignet sich ideal, wenn Sie komplexe AI- und Machine-Learning-Workloads, offene Architekturen oder modulare Kontrolle benötigen. Databricks bietet:

- Vollständige Kontrolle über die Architektur (Lakehouse)

- Offene Standards wie Delta Lake und MLflow

- Native Unterstützung für generative KI und Large Language Models

- Höchste Skalierbarkeit für große Datenmengen

- Integration mit Azure, AWS und GCP

Typische Szenarien:

- Aufbau von ML-getriebenen Produkten und Services

- Ablösung bestehender Hadoop- oder DWH-Infrastrukturen

- Modularer Plattformansatz mit hohem Engineering-Know-how

So helfen wir bei der Auswahl: Unser Data Platform Discovery Workshop

Technische Vergleiche sind hilfreich – aber sie ersetzen keine unternehmensspezifische Bewertung. Deshalb bieten wir einen Discovery Workshop an, in dem wir gemeinsam mit Ihnen:

- Ihre Ausgangssituation analysieren

- Potenziale und Herausforderungen identifizieren

- Plattformoptionen technisch und strategisch bewerten

Bei der Auswahl einer Datenplattform arbeiten wir mit einem strukturierten Fünf-Phasen-Modell, das Unternehmen hilft, eine objektive und fundierte Entscheidung zu treffen.

- Analyse

Wir erfassen alle relevanten Anforderungen: bestehende Herausforderungen, gewünschte Use Cases, Integrationsbedarf, Datenstrategie und Budget. Das Ergebnis ist eine klar priorisierte Anforderungsliste. - Bewertung

Auf Basis der Anforderungen erstellen wir eine Longlist potenzieller Plattformen (z. B. Databricks, Snowflake, Microsoft Fabric). Dabei berücksichtigen wir Datenmengen, technische Rahmenbedingungen und zukünftige Skalierbarkeit. - Strategie & Shortlist

Aus der Longlist entwickeln wir eine Shortlist mit ein bis zwei Plattformen. Wir analysieren grob die Betriebskosten und prüfen, welche vorhandenen Systeme konsolidiert oder ersetzt werden können. - Proof of Concept (PoC)

In einem PoC testen wir die favorisierten Plattformen anhand eines realen Use Cases mit echten Daten. So lassen sich Usability, Integration, Performance und Entwicklungsprozesse realistisch bewerten. - Auswahl & Empfehlung

Die getesteten Plattformen werden anhand eines Bewertungskatalogs objektiv verglichen. Daraus entsteht eine belastbare Entscheidungsvorlage – nachvollziehbar dokumentiert und strategisch fundiert.

Dieses Vorgehen hat sich in zahlreichen Kundenprojekten bewährt und schafft die Grundlage für eine zukunftsfähige Datenarchitektur.

Natürlich gibt es auch viele andere Anbieter auf dem Markt. Doch nicht jede Plattform hält, was sie verspricht – sei es bei Kosten, Offenheit oder AI-Fähigkeiten. Im nächsten Kapitel werfen wir deshalb einen kritischen Blick auf Snowflake, SAP BDC, Palantir & Co.

Kritischer Blick auf andere Plattformen: Snowflake, SAP BDC, Palantir & Co.

Viele Datenplattformen werben mit einfachen Versprechen: „Schnell einsatzbereit“, „Keine Infrastruktur notwendig“, „Skalierbar und sicher“. Doch im Projektalltag zeigt sich oft ein anderes Bild. Im Folgenden geben wir einen ehrlichen Einblick, wo häufig genannte Alternativen im Vergleich zu Fabric und Databricks an Grenzen stoßen – technisch wie wirtschaftlich.

Snowflake: Einfach zu nutzen – aber teuer bei wachsendem Bedarf

Snowflake hat sich als beliebte Cloud-Datenplattform etabliert, insbesondere für Unternehmen mit Fokus auf klassischem Reporting. Die einfache Benutzeroberfläche und die Trennung von Compute und Storage sind Vorteile – doch unter der Haube lauern Herausforderungen:

- Kostenfallen bei komplexen Workloads: Je mehr Transformationen, desto höher der Credit-Verbrauch – besonders bei inkrementellen ETL-Prozessen.

- Fehlende AI/ML-Integration: Kein integriertes Modelltraining, keine Notebook-Umgebung – AI ist meist nur über externe Tools möglich.

- Proprietäres Datenformat: Kein Delta Lake oder Parquet – erschwert Portabilität und erschafft Lock-in-Effekte.

Fazit: Für reine BI-Workloads mit klaren Datenmodellen gut geeignet – für moderne AI- und Data-Science-Plattformen zu eingeschränkt.

SAP Business Data Cloud (BDC): Gut integriert – aber proprietär und unflexibel

BDC ist die logische Wahl für SAP-zentrierte Unternehmen – bietet aber nur eingeschränkte Offenheit für moderne Datenarchitekturen:

- Always-on-Kapazitätsmodell: Lizenzen laufen durchgehend – unabhängig davon, wie viel wirklich genutzt wird.

- Geschlossene Datenformate: Erschweren Integrationen mit offenen Cloud-Tools (z. B. Databricks, BigQuery).

- AI ist nachgelagert: ML-Funktionen sind vorhanden, aber kein Fokus – eher ein Add-on zu bestehenden Business-Anwendungen.

Fazit: Wenn SAP das Herz der IT bildet, ist BDC sinnvoll – für offene Plattformstrategien eher ungeeignet.

Palantir Foundry: Mächtig – aber komplex und schwer zugänglich

Palantir hat sich im öffentlichen Sektor und in sicherheitskritischen Bereichen etabliert. Die Plattform bietet enorme Governance- und Datenverknüpfungskapazitäten – ist aber:

- Schwer zu beschaffen: Längere Vertragslaufzeiten, undurchsichtige Lizenzmodelle.

- Hochgradig proprietär: Erfordert spezielle Schulungen und Experten, geringe Verfügbarkeit im freien Markt.

- Komplex: Die Komplexität lohnt sich nur bei sehr datenintensiven operativen Prozessen.

Fazit: Für sicherheitsrelevante Anwendungen mit starkem Echtzeitbedarf geeignet – für typische BI- oder AI-Projekte meist überdimensioniert.

SAS Viya: Stark in regulierten Branchen – aber proprietär und teuer

SAS ist bekannt für seine statistischen Verfahren und seine stabile Performance im Finanz- und Gesundheitswesen. Die Plattform Viya bringt moderne Cloudfähigkeit mit – jedoch:

- Proprietär bis ins Detail: Eigene Sprachen, eigene Engine, eigene Modellierungsansätze.

- Teure Lizenzen: Oft jenseits dessen, was KMU oder datengetriebene Mittelständler bereit sind zu investieren.

- Schlechte Portierbarkeit: Einmal SAS, immer SAS – Migrationen sind technisch und wirtschaftlich schwierig.

Fazit: Ideal für sehr spezifische Anforderungen in regulierten Branchen – als zentrale Plattform für offene, skalierbare Architekturen jedoch nicht erste Wahl.

| Plattform | Herausforderungen im Projektalltag |

|---|---|

| Snowflake | Verdeckte Kosten durch Credit-Verbrauch, schwache AI-Funktionalität |

| SAP BDC | Always-on-Lizenzen, geschlossene Architektur, wenig Innovationsspielraum |

| Palantir | Lizenzkomplexität, geringe Verfügbarkeit von Know-how, hoher Einstieg |

| SAS Viya | Proprietär, teuer, schwierig zu integrieren in moderne Cloud-Stacks |

Fazit: Die passende Datenplattform ist kein Zufall – sondern Strategie

Datenplattformen bilden das Fundament jeder modernen Datenstrategie – und damit auch jeder erfolgreichen KI-Initiative. Doch der Markt ist unübersichtlich: Während einige Anbieter mit Benutzerfreundlichkeit punkten, überzeugen andere mit offener Architektur, AI-Power oder SAP-Nähe.

Unsere Analyse zeigt:

- Microsoft Fabric ist ideal für Unternehmen im Microsoft-Umfeld, die eine vollständig integrierte Plattform suchen, schnell starten wollen und Self-Service ermöglichen möchten.

- Databricks ist die Plattform der Wahl für anspruchsvolle AI- und Data Engineering-Szenarien – offen, skalierbar, cloudübergreifend und mit starker Entwickler-Community.

- Snowflake, SAP BDC, Palantir und SAS haben ihre Berechtigung – sind aber oft zu teuer, zu geschlossen oder zu spezialisiert für eine zukunftsfähige, unternehmensweite Datenstrategie.

Unsere Empfehlung: Wählen Sie keine Plattform aus dem Bauch heraus – sondern auf Basis konkreter Anforderungen, Use Cases und technischer Machbarkeit.

Dafür bieten wir Ihnen mit unserem Discovery Workshop einen klar strukturierten Einstieg:

- Identifikation relevanter Use Cases

- Technische und wirtschaftliche Bewertung mit dem ICE-Framework

- Ergebnis: eine priorisierte Datenstrategie mit Plattformempfehlung

Ob Microsoft Fabric, Databricks oder eine hybride Lösung – wir unterstützen Sie dabei, die richtige Entscheidung zu treffen und Ihre Datenplattform zukunftssicher aufzubauen.

Lassen Sie uns sprechen und Ihr Potenzial entdecken.

Ob und wie künstliche Intelligenz Ihnen weiterhelfen kann, können Sie in einem ersten, unverbindlichen Gespräch mit uns herausfinden.

In diesem Gespräch erfahren Sie:

- Wie Ihr Use-Case technisch am besten umgesetzt werden kann

- Wie wir maximal sicher mit Ihren Kundendaten umgehen

- Wie lange wir für die Umsetzung benötigen und wie ein konkreter Projektplan aussehen könnte

FAQ – Antworten auf häufige Fragen

Databricks nutzt ein nutzungsbasiertes Preismodell, bei dem sogenannte „Databricks Units“ (DBUs) pro Rechenleistung und Laufzeit abgerechnet werden. Je nach Cluster-Größe, Region und Runtime können die Kosten stark variieren – realistisch sind ab ca. 0,20 € bis 1,50 € pro Stunde je DBU. Hinzu kommen Storage-Kosten in der Cloud.

Fabric verwendet ein Kapazitätsmodell (Capacity Units) ähnlich wie Power BI Premium. Für kleinere Teams mit vielen Power-BI-Nutzern kann das günstiger sein als ein vollständig modulares Setup mit Synapse + ADF + ML. Bei datenintensiven Szenarien ist Databricks oft effizienter – insbesondere für AI.

Nein. Fabric ist zwar tief in Microsoft 365 und Azure eingebettet, kann aber auch Daten aus AWS, Google Cloud oder SAP-Systemen integrieren – über OneLake, Dataflows oder APIs. Der Einstieg fällt besonders leicht, wenn Power BI bereits genutzt wird.

Grundsätzlich ja – allerdings mit Einschränkungen: SAP BDC ist nicht offen im Datenformat und setzt oft auf SAP-Logiken, Transformationsregeln und Governance-Strukturen. Die Integration externer Systeme ist aufwendig und teils lizenzpflichtig.

Ja. Plattformen wie SAS Viya, Palantir Foundry (hybrid) oder native Azure-Komponenten (z. B. mit Synapse in Managed VNETs) können on-prem oder im Rechenzentrum betrieben werden. Die meisten modernen Plattformen sind jedoch cloud-first – mit klaren Vorteilen bei Skalierung, Wartung und Kosten.

Dann drohen hohe Migrationskosten, verlorene Entwicklungszeit oder unflexible Strukturen. Deshalb empfehlen wir vor der Auswahl eine technisch fundierte Validierung – z. B. durch einen Proof of Concept (PoC) oder unseren Discovery Workshop mit ICE-Framework.

Je nach Plattform, Datenlage und Teamstruktur dauert eine erste produktive Einführung zwischen 4 Wochen (MVP) und 6 Monaten (skaliert). Besonders schnell gelingt der Start mit Fabric oder Databricks in Kombination mit bestehenden Azure-Ressourcen.

Ja. Databricks übernimmt z. B. das AI- und Datenengineering, während Fabric als Self-Service- und Reporting-Layer für Fachbereiche genutzt wird. Beide Plattformen lassen sich über OneLake, Delta Lake oder Power BI nahtlos integrieren.

ICE steht für Impact, Confidence und Ease. Es ist ein praxisbewährtes Modell zur Bewertung von KI-Use-Cases nach Geschäftsnutzen, Umsetzbarkeit und Geschwindigkeit. Wir nutzen es in unserem Discovery Workshop, um gemeinsam mit Ihnen eine fokussierte KI-Roadmap zu erstellen.