Die Integration von Power BI und Databricks ist ein zentrales Thema in vielen Unternehmen, da sie den Brückenschlag zwischen einer skalierbaren Datenplattform und flexibler Business-Intelligence (BI) ermöglicht. Als Partner von Databricks unterstützen wir unsere Kunden bei der Umsetzung.

In diesem Blogbeitrag zeigen wir Ihnen, wie Sie Power BI in Databricks integrieren, welche Möglichkeiten es gibt und welche Voraussetzungen Sie erfüllen müssen.

Das erwartet Sie in diesem Blog:

- Überblick über die neuen nativen Integrationsmöglichkeiten von Power BI und Databricks.

- Erklärung der drei Hauptwege: One-Click Publish, Lakeflow Tasks und Power BI Desktop Connector.

- Vorteile durch Unity Catalog: zentrale Governance, Sicherheit und weniger Fehleranfälligkeit.

- Voraussetzungen für die Nutzung (z. B. Power BI Premium/Fabric, Unity Catalog).

- Ausblick auf kommende Features wie inkrementelle Datenverarbeitung in Power BI.

Für Sie auch interessant:

Warum neue Integrationsmöglichkeiten?

In den meisten Projekten wurde bisher der klassische Weg (über JDBC/ODBC Connection der DBSQL Datenbank) der Integration gewählt.

Dies hatte zur Folge, dass viele Informationen – bis hin zur Governance – mehrfach gepflegt werden mussten. Dieses Vorgehen ist jedoch arbeitsintensiv und fehleranfällig.

Aus diesem Grund hat Databricks in enger Zusammenarbeit mit Azure bzw. Power BI neue Verbindungsmöglichkeiten – über die Nutzung des Unity Catalogs – geschaffen.

Durch die native Integration beider Technologien eröffnen sich für Anwender zahlreiche Vorteile und neue Funktionen, die im Folgenden näher beleuchtet werden.

Was ist neu?

Die hauptsächliche Neuerung besteht in den Funktionen eines neuen Konnektors. Anstelle von mehrstufigen Integrationsprozessen wurde eine native Verbindungsmöglichkeit geschaffen. Diese kann Daten „out of the box“ in Power BI laden und das mit einem massiven Vorteil: Die Metadaten und Entity Relationships des Unity Catalogs werden übernommen (Permissions nur im Direct Query Mode).

Das bedeutet, dass Schemata, Semantik, Kommentare sowie Primary- und auch Foreign-Keys direkt mit übertragen werden. Außerdem wird die Governance durch den Unity Catalog sichergestellt (nur im Directy Query Mode).

Dies führt zu einer weniger Aufwand und geringerer Fehleranfälligkeit, da die Daten zentral verwaltet werden.

Weiterhin werden Sicherheitsrichtlinien durch die native Integration mit Microsoft Entra ID (AAD) unterstützt. Die Integration von Unity Catalog, Power BI und Microsoft Entra ID sorgt für maximale

- Sicherheit,

- Governance

- und Transparenz.

Sie können Power BI-Semantikmodelle so konfigurieren, dass sie OAuth mit Single Sign-On nutzen – damit werden Zugriffsrechte bei jeder Dashboard-Abfrage eingehalten. Gleichzeitig stehen die vollständigen Governance- und Observability-Funktionen des Unity Catalogs zur Verfügung. Diese Verknüpfung erhöht Sicherheit und Compliance durch nahtlose

- Autorisierung,

- Authentifizierung,

- und Zugriffskontrolle

zwischen Databricks- und Power BI-Umgebungen.

Die Integrationsmöglichkeiten von Power BI in Databricks

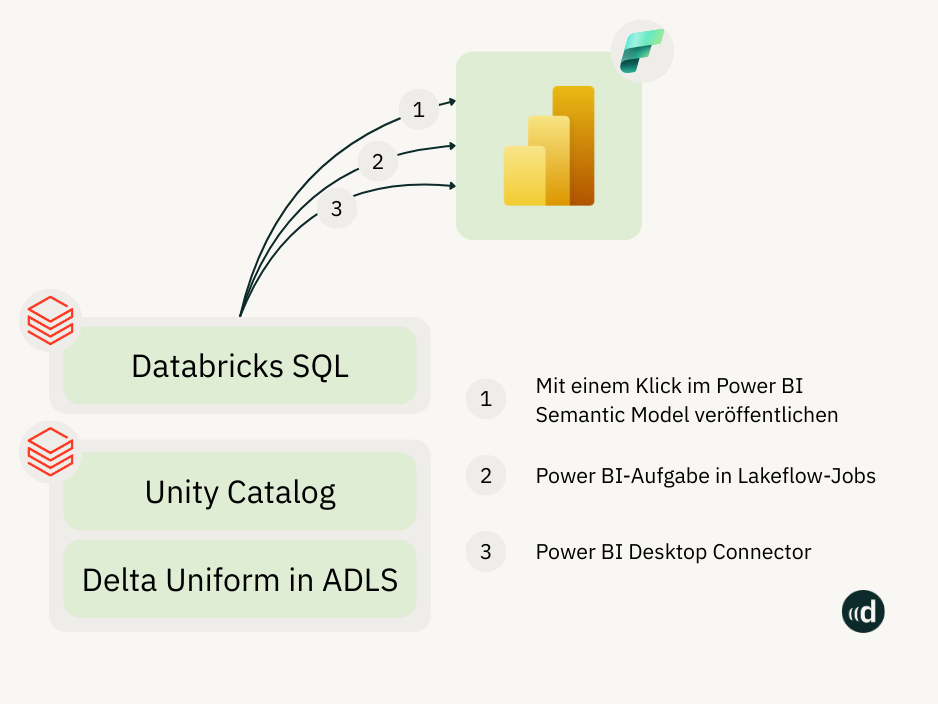

Die folgende Grafik zeigt die verschiedenen Integrationswege auf:

Generell startet der Datenfluss im Datalake in ADLS. Die komplette Governance wird durch Nutzung des Unity Catalogs realisiert.

Die Daten werden über das DBSQL Data Warehouse über einen der drei hauptsächlichen Integrationsmöglichkeiten an Power BI übertragen.

1. One-Click Publish:

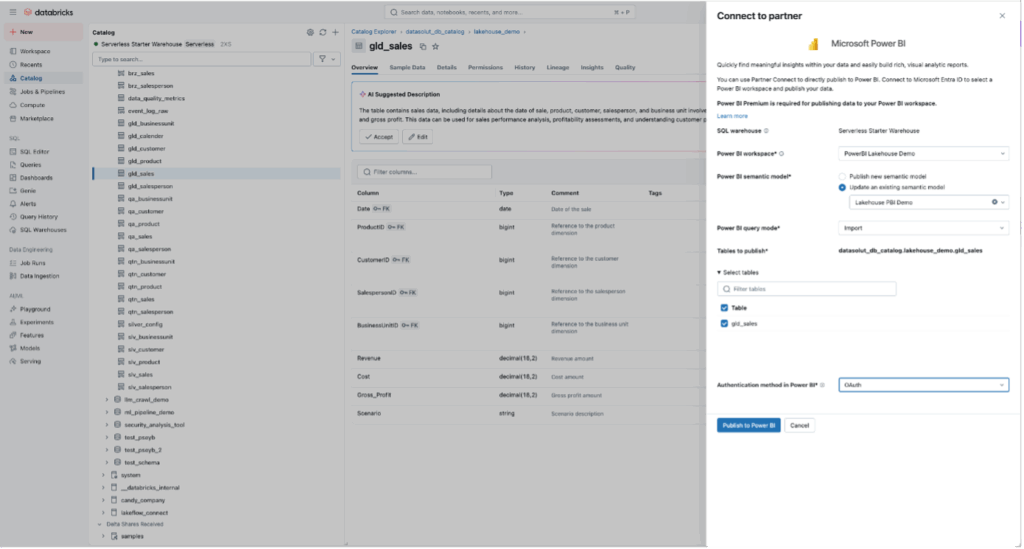

Die erste Möglichkeit der Datenübertragung ist das One-Click Publish. Dabei werden die ausgewählten Daten über einen Klick (in der Databricks UI) als semantisches Modell in Power BI verfügbar.

Der folgende Screenshot zeigt dies exemplarisch auf:

Die Notwendigkeit eines Power BI Desktop Clients enfällt damit. Diese Integrationsmöglichkeit eignet sich vor allem für Ad hoc-Übertragungen und Unternehmen, die standardisierte Datenmodelle an mehrere Teams ausrollen möchten, ohne redundante Workflows zu pflegen.

2. Tasks in Lakeflow Jobs:

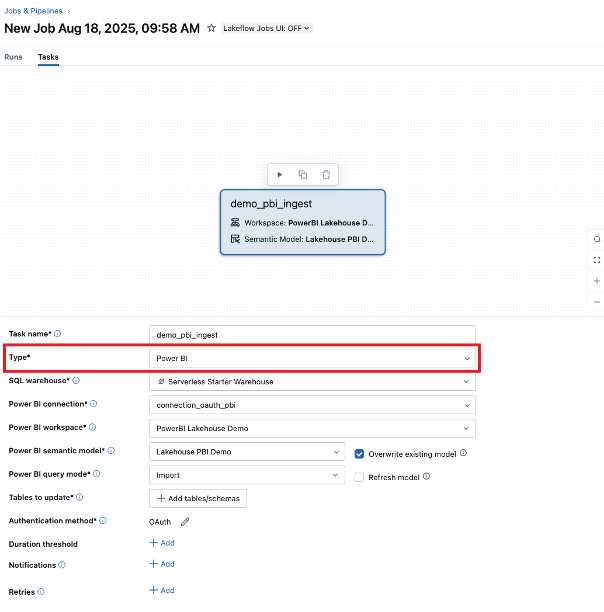

Ein weiterer Weg der Integration funktioniert über einen neuen Task Typ in Databricks Workflows. Dieser dient dem Update und neuen Laden der Power BI-Semantikmodelle.

Power BI-Tasks sind in Databricks Workflows integriert, sodass Sie deren Orchestrierungs- und Monitoring-Funktionen nutzen können. Das bedeutet:

Sie können Features wie Abhängigkeiten zwischen Tasks, Zeitpläne/Trigger, Wiederholungen und Benachrichtigungen auch für Datenpipelines einsetzen, die Power BI-Tasks enthalten.

So stellen Sie sicher, dass durch den automatisierten Job stets alle Daten für Berichte und Dashboards aktuell sind.

Power BI-Tasks unterstützen das

- Veröffentlichen,

- Aktualisieren

- und Refreshen

von Semantikmodellen in den Modi

- Import,

- Direct Query

- und Dual Storage.

So haben Sie maximale Flexibilität, um Performance und Sicherheit auszubalancieren. Außerdem entfällt der Kontextwechsel zwischen Databricks und Power BI. Der Prozess, Daten für Visualisierungen und Analysen bereitzustellen, wird vereinfacht.

Databricks Beratung mit Datasolut

Ein wesentlicher Vorteil im Direct Query Modus ist, dass Sie Berechtigungen aus dem Unity Catalog runter bis in die Spaltenebene geben können.

Weiterhin werden Unity Catalog-Objekte wie

- Tabellen,

- Views,

- materialisierte Views

- und Streaming-Tabellen unterstützt.

Der große Vorteil: Sie können Power BI-Semantikmodelle auf Basis von Unity Catalog-Datenobjekten aus mehreren Schemas und Catalogs aufbauen.

Erweiterbarkeit steht im Mittelpunkt: Power BI-Tasks lassen sich sowohl visuell in der Databricks Jobs UI nutzen als auch programmatisch über die Jobs API und Databricks Asset Bundles steuern.

Der folgende Screenshot zeigt die Auswahl einer Power BI-Task:

Damit eignet sich diese Art der Integration vor allem für regelmäßige und regelbasierte Datenflüsse.

3. Power BI Desktop Connector

Die dritte Verbindungsmöglichkeit ist der Power BI Desktop Connector. Dieser ist vor allem für Benutzer geeignet, die nicht auf die Power BI Desktop Applikation verzichten wollen.

Dies kann beispielsweise in der Entwicklung und Verwaltung von Power BI sinnvoll sein. Die Funktionalität wurde dahingehend erweitert, dass Sie auch über die Vorzüge der anderen beiden Verbindungsarten verfügt.

Welche Voraussetzungen müssen erfüllt sein?

Um die native Integration zwischen Power BI und dem DBSQL Data Warehouse nutzen zu können, müssen folgende Voraussetzungen gegeben sein:

- Ihre Daten müssen sich in Unity Catalog befinden, und Ihre Compute-Ressourcen (Cluster) müssen in Unity Catalog aktiviert sein. Ein Hive-Metastore wird derzeit nicht unterstützt.

- Sie müssen über eine Power BI-Lizenz (Premiumkapazität, Premium pro Benutzerlizenz oder Fabric-Kapazität) verfügen.

- Wenn Benutzer nach der Veröffentlichung semantische Modelle im Power BI Service bearbeiten möchten, müssen Sie die Funktion „Benutzer können Datenmodelle im Power BI Service (Vorschau) bearbeiten“, in den Arbeitsbereichseinstellungen aktivieren. Sie können das Semantikmodell auch mithilfe des Tabular-Editors bearbeiten, indem Sie eine Verbindung mit dem XMLA-Endpunkt herstellen.

- Wenn Ihr Power BI-Arbeitsbereich einen Private-Link verwendet, müssen Sie die Datenquellenanmeldeinformationen des Datasets manuell in Power BI aktualisieren.

Ausblick: Inkrementelle Datenverarbeitung in Power BI

Das inkrementelle Updaten von Informationen bietet heute schon massive Vorteile innerhalb der Databricks Datenverarbeitung und -aufbereitung. Diese Funktionalität soll zukünftig auch für Power BI verfügbar sein.

Dieses Vorgehen schont Ressourcen und erhöht die Geschwindigkeit der Aktualisierungen. Außerdem stellt man damit sicher, dass die genutzten Datensätze stets aktuell sind.

Kurzum: Die Effizienz wird erhöht und Kosten reduziert.

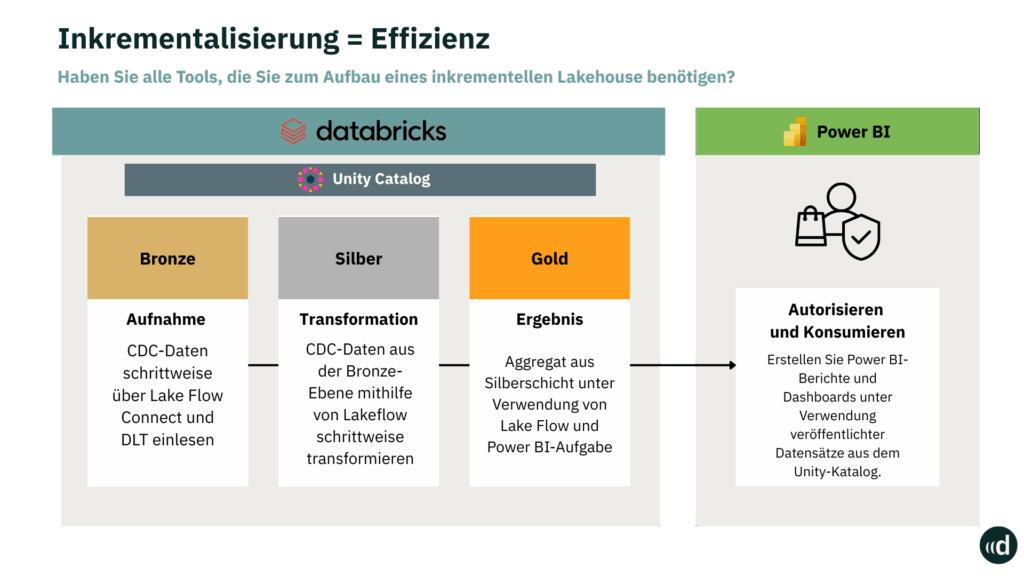

Anhand der folgenden Grafik wird die geplante Erweiterung deutlicher:

Die Grafik zeigt, wie heute Daten zwischen den unterschiedlichen Layern (Bronze, Silver, Gold) inkrementell verarbeitet werden.

In Zukunft wird es also z.B. möglich sein, semantische Modelle nur inkrementell in Power BI zu updaten, anstatt das gesamte Modell neu zu laden.

Weitere Features und Hinweise

Neben den bereits genannten Vorteilen und Neuerungen, gibt es einige spezifische Features und Hinweise, die wir an dieser Stelle noch mit aufführen möchten:

- Kommentare zu den Spalten einer Tabelle in Azure Databricks werden in die Beschreibungen der entsprechenden Spalten in Power BI kopiert.

- Fremdschlüsselbeziehungen werden im veröffentlichten Datensatz beibehalten. Power BI unterstützt jedoch nur einen aktiven Beziehungspfad zwischen zwei Tabellen. Wenn das Schema in Azure Databricks mehrere Pfade enthält, werden einige der entsprechenden Beziehungen in Power BI als inaktiv festgelegt. Sie können später in der Datenmodellansicht in Power BI ändern, welche Beziehungen aktiv und welche inaktiv sind.

- Bei Verwendung von OAuth oder eines lokalen Datengateways müssen Anmeldedaten gegebenenfalls auf der Seite mit den Einstellungen für Power BI-Datasets unter „Anmeldedaten für die Datenquelle“ konfiguriert werden.

- Es wird sowohl der Import Mode, der Direct Query Mode, als auch eine Kombination aus beiden Modi (Composite Mode) unterstützt.

Fazit

Aus der Praxis können wir sagen, dass die native Integration von Power BI und Databricks – mit Unterstützung des Unity Catalogs – einen entscheidenden Fortschritt für Unternehmen, die Daten effizient, sicher und skalierbar nutzen wollen, markiert. Durch die neuen Connector-Funktionen entfällt der Aufwand redundanter Integrationspfade, während Governance, Sicherheit und Transparenz durchgängig gewährleistet sind.

Einzig die Notwendigkeit der Premium- oder Fabric-Power BI-Lizenzen bildet eine finanzielle Hürde, die die Umsetzung nicht in allen Projekten rechtfertigt oder budgetär abbildbar ist.

Unserer Meinung nach profitieren unsere Kunden von vereinfachten Workflows, höherer Datenqualität und geringerer Fehleranfälligkeit. Ob über One-Click Publish für schnelle Bereitstellungen, Tasks in Lakeflow Jobs für automatisierte und wiederkehrende Datenprozesse oder den Power BI Desktop Connector für Entwickler.

Mit Blick auf zukünftige Features wie die inkrementelle Datenverarbeitung (auch) in Power BI wird zudem klar: Die Integration ist nicht nur eine technische Verbindung, sondern ein Enabler für zukunftsorientierte Datenstrategien, die Performance und Compliance gleichermaßen berücksichtigen.

Lassen Sie uns sprechen und Ihr Potenzial entdecken.

Ob und wie künstliche Intelligenz Ihnen weiterhelfen kann, können Sie in einem ersten, unverbindlichen Gespräch mit uns herausfinden.

In diesem Gespräch erfahren Sie:

- Wie Ihr Use-Case technisch am besten umgesetzt werden kann

- Wie wir maximal sicher mit Ihren Kundendaten umgehen

- Wie lange wir für die Umsetzung benötigen und wie ein konkreter Projektplan aussehen könnte

FAQ – Wichtige Fragen, schnelle Antworten

Es stehen drei Wege zur Verfügung:

One-Click Publish für schnelle Bereitstellung von Datenmodellen

Lakeflow Tasks für automatisierte und wiederkehrende Datenprozesse

Power BI Desktop Connector für Entwickler und komplexe Modellierung

Unity Catalog sorgt für zentrale Governance, Sicherheit und Transparenz. Schemata, Metadaten, Keys und Berechtigungen werden direkt in Power BI übernommen.

1. Daten müssen im Unity Catalog liegen

2. Compute-Ressourcen müssen Unity Catalog-fähig sein

3. Eine Power BI Premium- oder Fabric-Lizenz ist erforderlich

Sie reduziert manuellen Aufwand, vermeidet redundante Workflows, verbessert Sicherheit durch Entra ID-Integration (SSO, OAuth) und erhöht die Datenqualität.

Der neue native Connector zwischen Databricks und Power BI, der Governance und Metadaten aus Unity Catalog automatisch berücksichtigt.