Erfolgreicher Aufbau und Live-Gang einer Databricks-Infrastruktur in der Finanzbranche

Auf einen Blick:

- Branche: Versicherungen

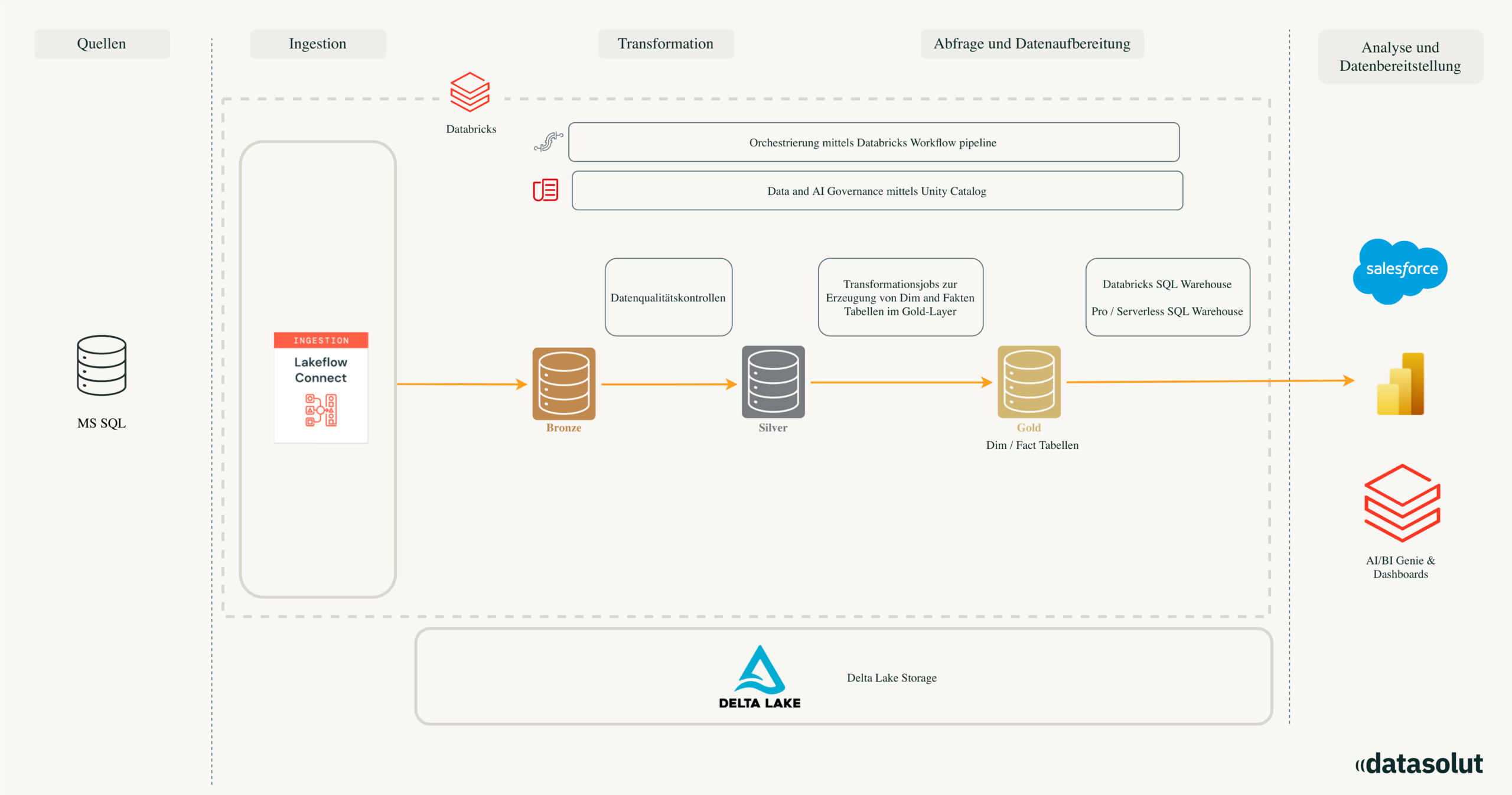

- Projektziel: Aufbau einer produktionsreifen AWS-Databricks-Plattform

- Tools: AWS, Databricks, Terraform, Databricks Asset Bundles, Python/Pyspark

- Beteiligte Personen: 4 Entwickler von Datasolut, 7 aus der internen Fachabteilung und IT und 1 externer Berater

Unser Kunde, ein führender Finanzvermittler, stand vor der Herausforderung, dass seine bestehende On-Prem-Dateninfrastruktur nicht mehr skalierbar war und die technologische Weiterentwicklung blockierte. Ein kritisches Problem war hierbei die geteilte Ressourcenauslastung zwischen den produktiven ERP-Systemen und den analytischen Datenapplikationen wie Power BI, was die Performance beider Welten einschränkte. Zudem war die bisherige Datenaufbereitung starr und individuell auf einzelne Reports zugeschnitten, wodurch sie weder flexibel noch wiederverwertbar aufgebaut war.

Besonders kritisch bewerteten wir aus der Datasolut-Perspektive die fehlenden Security- und Governance-Funktionalitäten: Es gab keine strukturierten Möglichkeiten, Zugriffe nach dem „Least Privilege“-Prinzip zu steuern, Loggings für Zugriffe zu erstellen oder die laufenden Applikationen lückenlos zu überwachen.

Ein weiteres zentrales Hindernis war die fehlende einheitliche Datenbasis; da je nach Reporting unterschiedliche, teils nicht rückverfolgbare Zahlen ausgegeben wurden, fehlte dem Kunden eine verlässliche Single-Source-of-Truth. Die problematische Ausgangslage wurde durch fehlende Data-Quality-Checks innerhalb der bestehenden Pipelines noch verschärft. Dadurch flossen unsaubere Daten ungefiltert in die Analysen ein, anstatt sie systematisch zu isolieren.

Wir haben diese Herausforderungen gelöst, indem wir eine moderne, produktionsreife Datenplattform auf Basis von Databricks und AWS implementiert haben, die Sicherheit, Governance und Datenqualität nativ vereint.

Um die Datenplattform Databricks tief in die Geschäftsprozesse des Kunden zu integrieren, basierte unser Lösungsansatz auf einer strukturierten Abfolge aufeinander aufbauender Arbeitspakete.

Das übergeordnete Ziel war es, Daten effizient zu integrieren und zu prozessieren, wobei wir im Projektverlauf flexibel auf neue Anforderungen reagierten: Während zu Beginn noch Salesforce und Power BI als Zielsysteme im Gespräch waren, passten wir den Projektscope agil an und fokussierten uns schließlich auf die Nutzung im Databricks Genie Space.

Wie gehen wir dabei vor?

1.

In Workshops definieren wir Geschäftslogik, relevante Prozesse sowie Datenquellen, Zielsysteme und Anforderungen entlang der Medallion Architecture.

2.

Wir setzen die Databricks-Plattform auf AWS automatisiert mit Terraform auf und etablieren Governance, Security, Rollen und Betriebsstandards.

3.

Auf Basis eines BEAM-Workshops entwickeln wir das Gold-Modell und realisieren stabile Datenpipelines inklusive Quality-Checks und Analyselayer.

Von der Anforderung zur Architektur: So lief die Implementierung der Databricks-Plattform

Die Umsetzung begann mit einem intensiven Business Understanding Workshop, in dem wir gemeinsam mit dem Kunden analysierten, wie Umsatz generiert und Kosten verursacht werden, um die dahinterliegenden Prozesse präzise abzubilden. Darauf folgte die detaillierte Anforderungsaufnahme entlang der Medallion Architecture, bei der wir Datenquellen, notwendige Transformationen und die Frequenz der Datenintegration definierten.

Den technischen Grundstein legten wir durch den Aufbau der Databricks- und AWS-Infrastruktur. Dabei setzten wir konsequent auf Terraform, konfigurierten Serverless-Strukturen und implementierten über den Unity Catalog ein durchdachtes Rechte- und Rollenkonzept sowie spezifische Cluster Policies.

Für das agile Design des Data Warehouse führten wir einen BEAM-Workshop* (Business Event Analysis & Modelling) durch. Dieser bildete die Basis für die Erarbeitung eines performanten Star-Schemas im Gold Layer. Den Abschluss bildete der Aufbau der Data Pipeline, bei der wir Daten von einem On-Prem SQL Server mittels Lakeflow Declarative Pipelines integrierten.

Die technische Umsetzung im Detail

Durch die Nutzung von Metric Views in Databricks schufen wir eine verlässliche Basis für den Gold-Layer. Die Dimension der verarbeiteten Daten unterstreicht die Leistungsfähigkeit der gewählten Architektur.

Vom Proof of Concept zum Vorstands-Reporting

Durch die konsequente Umsetzung der neuen Plattform konnten wir Ergebnisse erzielen, die weit über eine rein technologische Modernisierung hinausgehen. Ein zentraler Erfolg war die Identifizierung und Quarantänisierung von über 3 Millionen fehlerhaften Datensätzen. Dieser Prozess schuf nicht nur eine verlässliche Datenbasis, sondern legte die Grundlage dafür, gezielte Prozessoptimierungen beim Kunden anzustoßen, um die Datenqualität bereits an der Quelle nachhaltig zu verbessern.

Während des Projekts ist es uns gelungen, dem Kunden eine völlig neue Klarheit über seine bestehenden Herausforderungen im Datenbereich zu verschaffen. Diese Transparenz ermöglichte eine präzise und fundierte Planung der nächsten strategischen Schritte.

Nach dem erfolgreichen Aufbau der Datenplattform und der Implementierung des Databricks Genie Space (siehe Use Case: Aufbau eines AI/BI Genie Space) ist die Roadmap für die Zukunft bereits klar definiert: In den kommenden 6 bis 12 Monaten werden kontinuierlich weitere Datenquellen integriert, um die Analysefähigkeiten und den Genie Space stetig weiterzuentwickeln.

Besonders stolz macht uns die Tatsache, dass wir dieses komplexe Vorhaben innerhalb kürzester Zeit und exakt im Zeitplan realisieren konnten. Dass wir das fertige Projekt pünktlich zum Jahresende „unter den Weihnachtsbaum legen“ durften, war ein besonderes Highlight der Zusammenarbeit. Das sah dann ca. so aus:

Der krönende Abschluss war die gemeinsame Präsentation der Ergebnisse vor dem Vorstand des Kunden, was einen wesentlichen Beitrag zur langfristigen Stärkung und Wertschätzung des Datenbereichs innerhalb des Unternehmens leistet.

Sie haben Fragen zum Thema Aufbau der Dateninfrastruktur. Dann melden Sie sich! Wenn Sie sich für weitere spannende Fakten rund um das Thema moderne Datenplattformen interessieren, schauen sie auch gerne bei unseren Leistungen vorbei.

Der nächste Schritt für Ihre Datenplattform

Wenn Sie aktuell prüfen, wie Ihre Databricks-Lakehouse-Architektur zukunftsfähig aufgestellt werden kann, ist ein kurzes Orientierungsgespräch oft hilfreicher als stundenlage Recherche.

In diesem Gespräch klären wir:

- wie Ihre Datenplattform strukturiert ist

- wo Reibung oder strukturelle Engpässe entstehen

- ob DSX Lakehouse für Sie der passende Ansatz ist