Aufbau einer zentralen Datenplattform in Microsoft Fabric

Auf einen Blick:

- Branche: Eventmanagement

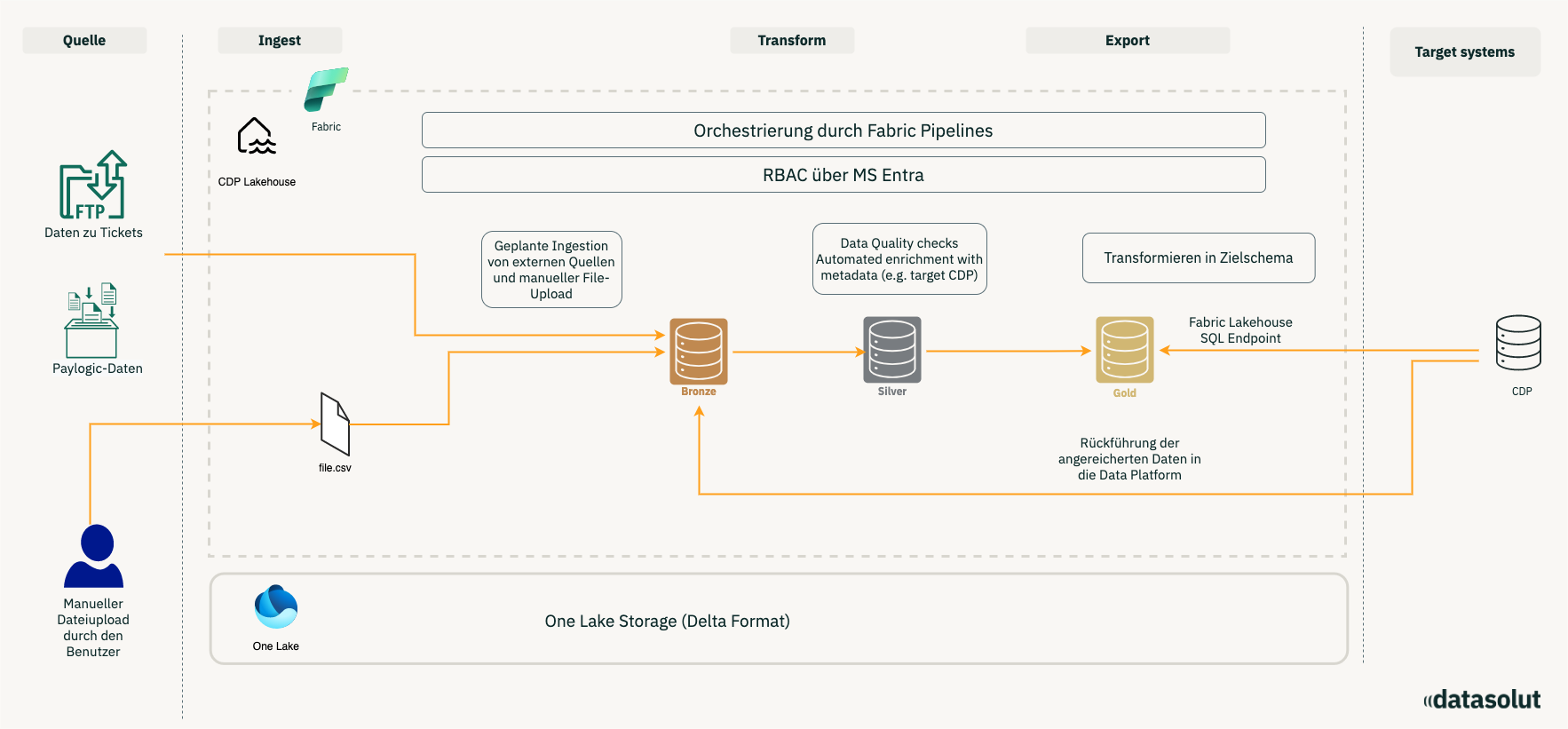

- Projektziel: Aufbau einer zentralen Datenplattform in Microsoft Fabric, um Ticket- und Kundendaten aus mehreren Systemen zu integrieren

- Tools: Microsoft Fabric, SFTP-Server, APIs, Python Notebooks, Python/PySpark

- Dauer: knapp 12 Wochen

- Anzahl beteiligter Mitarbeiter: 10

Bisher agierte unser Kunde – einer der größten Konzert- und Festivalveranstalter Europas – ohne einheitliche Datenbasis. Wertvolle Informationen, wie Verkaufsdaten externer Ticketplattformen, flossen nicht zentral zusammen, sondern verblieben in Datensilos ohne Kundenbezug.

Das Ergebnis: Ein lückenhaftes Kundenverständnis und eine fehlende Kontrolle über die Datenqualität, insbesondere bei den Postanschriften.

Während der Implementierung deckten wir zudem eine kritische Lücke in der Datenbereitstellung auf: Ein Dienstleister lieferte statt eines Full-Extracts lediglich Momentaufnahmen aktueller Events, was die historische Analyse zunächst einschränkte.

Wir haben das Projekt als Proof of Concept (PoC) gestartet und nach erfolgreichem Abschluss in ein skalierbares Produktivsystem überführt. Als technisches Fundament haben wir dafür Microsoft Fabric als zentrale Datenplattform implementiert.

Unsere Lösung

In der ersten Phase haben wir Ticketdaten einer Quelle via SFTP angebunden, die seither automatisiert und inkrementell auf nächtlicher Basis integriert werden.

Die Datenverarbeitung erfolgt entlang einer Medallion-Architektur, in der wir ein intensives Data Cleaning etabliert haben. Hierbei bereinigen und vereinheitlichen wir Adressdaten (Städte, PLZ, Länderkürzel) systematisch. Zur Absicherung haben wir eine zweistufige Qualitätskontrolle integriert: Soft Checks neutralisieren fehlerhafte Felder durch NULL-Werte, während Hard Checks inkonsistente Datensätze in eine Quarantäne-Tabelle aussteuern. Dies stellt sicher, dass nur valide Daten den Gold-Layer erreichen, und ermöglicht es uns gleichzeitig, Ursachen für Datenfehler im Quellsystem rückwirkend zu identifizieren und zu beheben.

Im Gold-Layer führen wir das Mapping auf das Zielmodell der neu eingeführten Customer Data Platform (CDP) durch und steuern den Datentransfer in enger Kooperation mit dem CDP-Anbieter. Inzwischen haben wir zwei weitere Ticketsysteme erfolgreich integriert.

Den Grundstein für die Zukunft haben wir bereits gelegt: In einem gemeinsamen Workshop haben wir weitere Use Cases definiert und für die Roadmap priorisiert mit Hilfe des bewährten ICE-Frameworks.

Vom Fundament zur Vision: Projektergebnisse und priorisierte Data & AI-Roadmap

Innerhalb von drei Monaten haben wir die Basis für die neue datengetriebene Architektur unseres Kunden geschaffen. Wir haben eine produktive End-to-End-Pipeline aufgebaut, die Ticketdaten nach höchsten Qualitätsstandards prozessiert und direkt in die Customer Data Platform überführt.

Um den langfristigen Erfolg zu sichern, haben wir zudem die strategische Planung übernommen: Aus 12 neu identifizierten Data & AI-Anwendungsfällen haben wir die Top 4 mithilfe des ICE-Frameworks priorisiert. Damit haben wir nicht nur ein funktionierendes System übergeben, sondern auch eine klare, wertorientierte Roadmap für die kommenden Monate entwickelt.

Sie wollen mit Fabric starten? Dann sind Sie bei uns an der richtigen Adresse!

Ihr nächster Schritt mit uns!

Wenn Sie aktuell prüfen, ob Microsoft Fabric der richtige Schritt ist, hilft ein kurzer Austausch mehr als weitere Recherchen. In einem Orientierungsgespräch klären wir.

- ob Fabric in Ihrer Situation sinnvoll ist

- welcher Einstieg den größten Nutzen bringt

- wie die nächsten Schritte aussehen könnte